Vision & Goals

Win-Win Community in the Agent Era

True AGI is still a decade away. Agent is the essential path. Seize the wave to stay relevant.

Through deep practice, knowledge sharing, and project collaboration, break down technical barriers and transform them into personal advantages and real value.

Empower everyone, win the Agent decade.

What We Offer

- · Systematic learning paths and practice manuals

- · One-on-one guidance from technical mentors and industry experts

- · Paper notes, cutting-edge talks, case co-creation

- · Portfolio polishing, resume & interview coaching, referrals

Advanced Play

Deep Co-creation · Papers/Projects/Career Full Chain

If you want to get started with LLM Agents

- •Learning paths and open-source repo recommendations

- •Intro courses + hands-on projects

- •Like-minded exchange community

If you want further collaboration / papers / career

- •Paper collaboration and experiment co-building

- •Industry landing project cooperation

- •Big tech job referrals and interview coaching

If you seek partnerships

- •Co-build community brand

- •Joint promotion and events

- •AI product and training guidance

Learning & Exploration

Carefully curated learning resources to help you quickly master Agent core technologies

Advanced Path

Community Projects / Papers

Idea2Story

An Agent framework that automatically generates top-tier conference-level paper narratives from ideas. Trained on tens of thousands of top conference papers and their review data, teaching AI to master "Scientific Storytelling".

Talks & Roundtables · Paper Reading

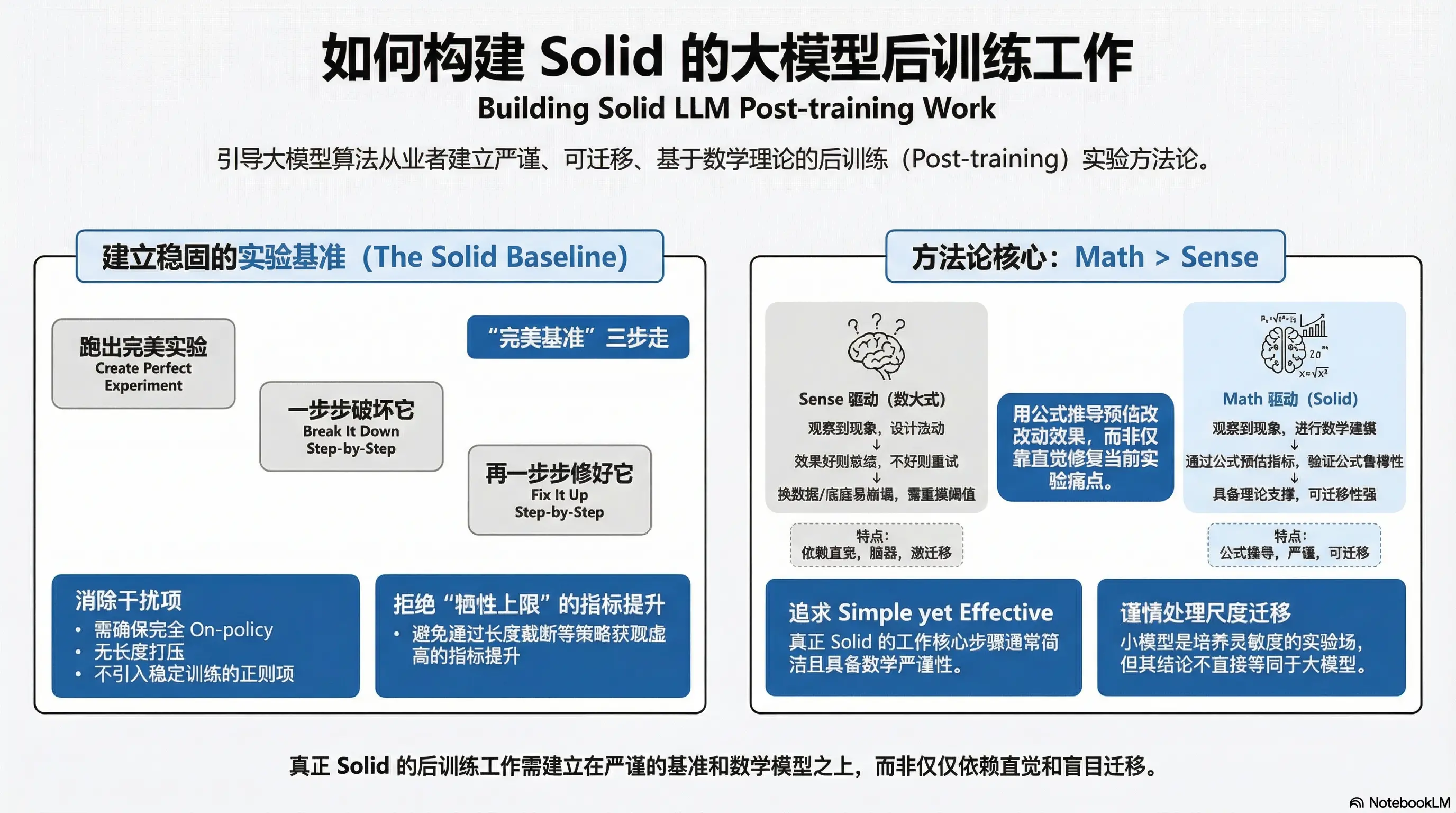

少用 sense 挑战 math!如何把 post train 做好,后训练方法论

作者:ybq https://zhuanlan.zhihu.com/p/1995265459285694156 LLM 论文千千万,有用的工作却没几篇。这篇文章,我想简单讨论下到底该如何把后训练工作做的 solid。文章并没什么技术细节,大家随便看看。 敲定正确的 Baseline 有太多论文工作不

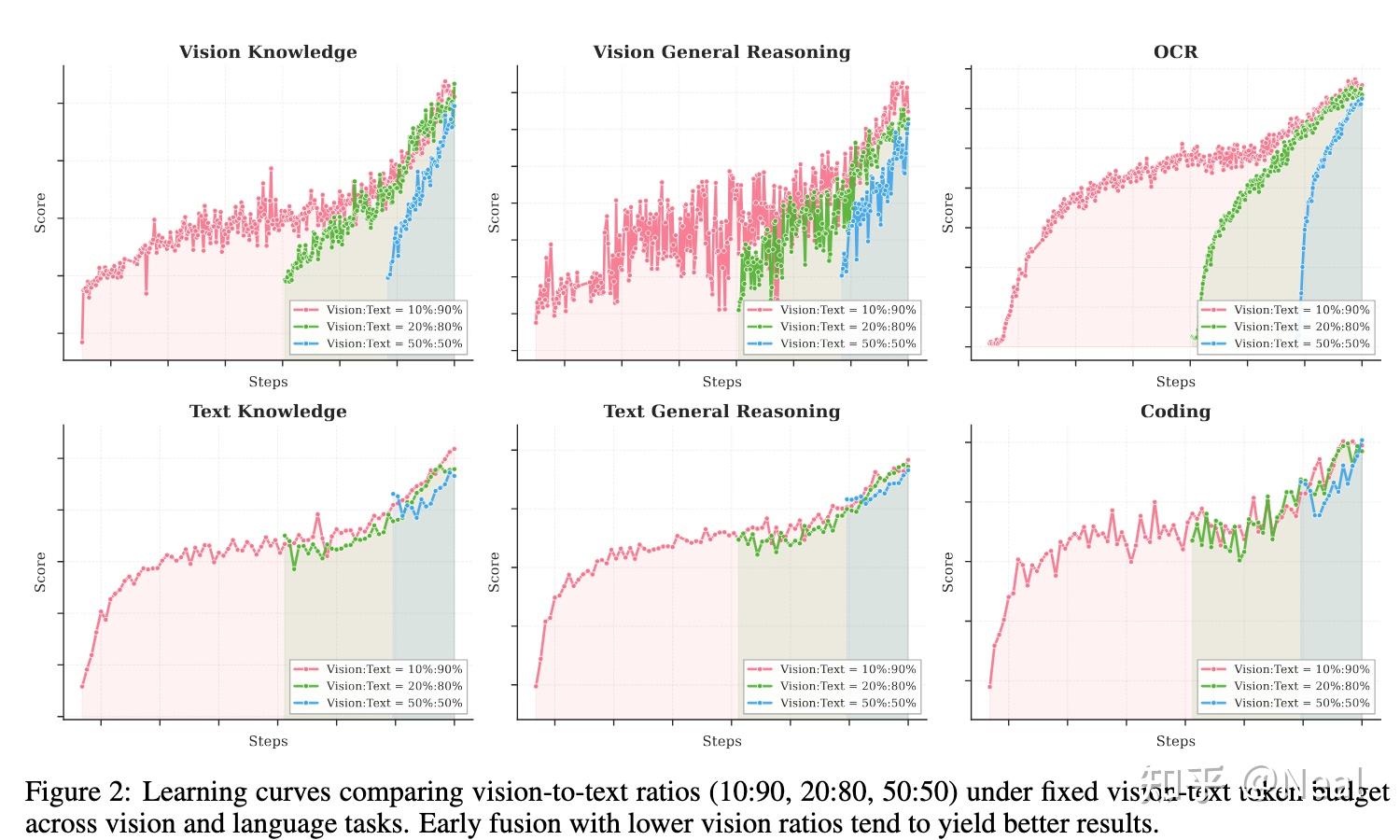

从 Pretrain 到 Agentic Vision:Kimi K2.5 的原生多模态训练之道

作者:Neal 链接:https://www.zhihu.com/question/1999487395494588876/answer/2000722695596299217 利益相关,在K2.5参与了Pretrain和部分Post-train的环节。本来想默默潜水,后面发现酒香也怕巷子深(还有很

Big Model Smell:Kimi K2.5 背后的 VLM 训练哲学与“N+1”范式

作者:Haoning Wu https://www.zhihu.com/question/1999487395494588876/answer/2000362433332660070 Big Model Smell 作为一个在这个项目里拧了几个月螺丝的工程师,release 之后看到大家讨论,挺多感

深度对话!2025 "青稞" AI 嘉年华,与 20+ 位青年科学家一起探讨AI 技术瞬间

本次活动专为青年科学家打造,旨在搭建一场 AI 技术的深度对话,来自学术和工业界的 20+ 青年科学家,将与大家一起回顾 2025,展望 2026!

TRPO重生:大模型时代的信任域策略优化

在大型语言模型的强化学习阶段,特别是RLHF中,我们追求策略的持续优化。本次分享深入探讨TRPO在LLM时代的应用。

从 π_0 到 π_RL:面向流匹配 VLA 的强化学习后训练框架

深入解析流匹配VLA的强化学习后训练框架π_RL,探索具身智能的前沿技术。

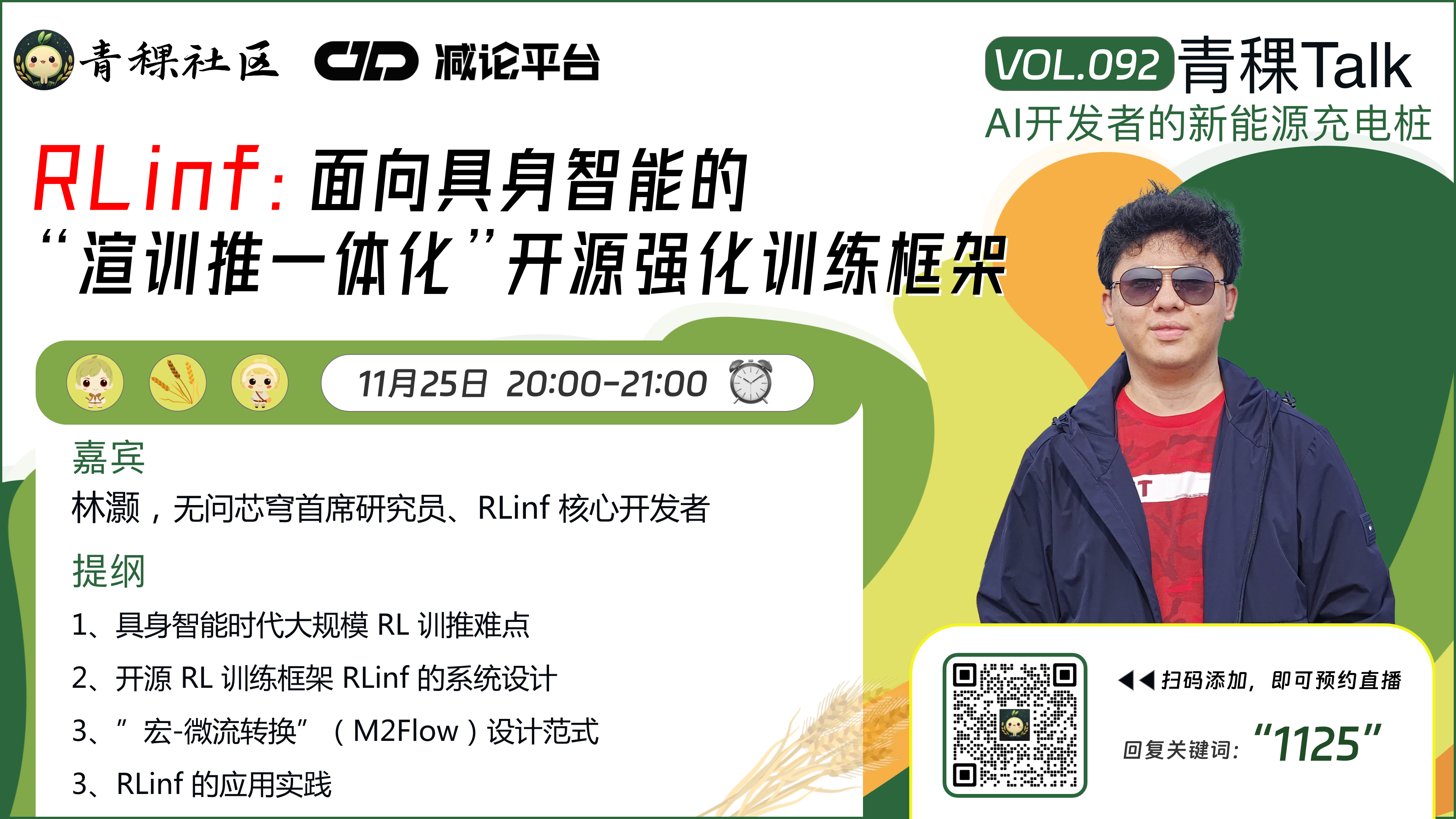

RLinf:面向具身智能的"渲训推一体化"开源强化训练框架

开源强化训练框架RLinf,实现渲染、训练、推理一体化,加速具身智能研发。

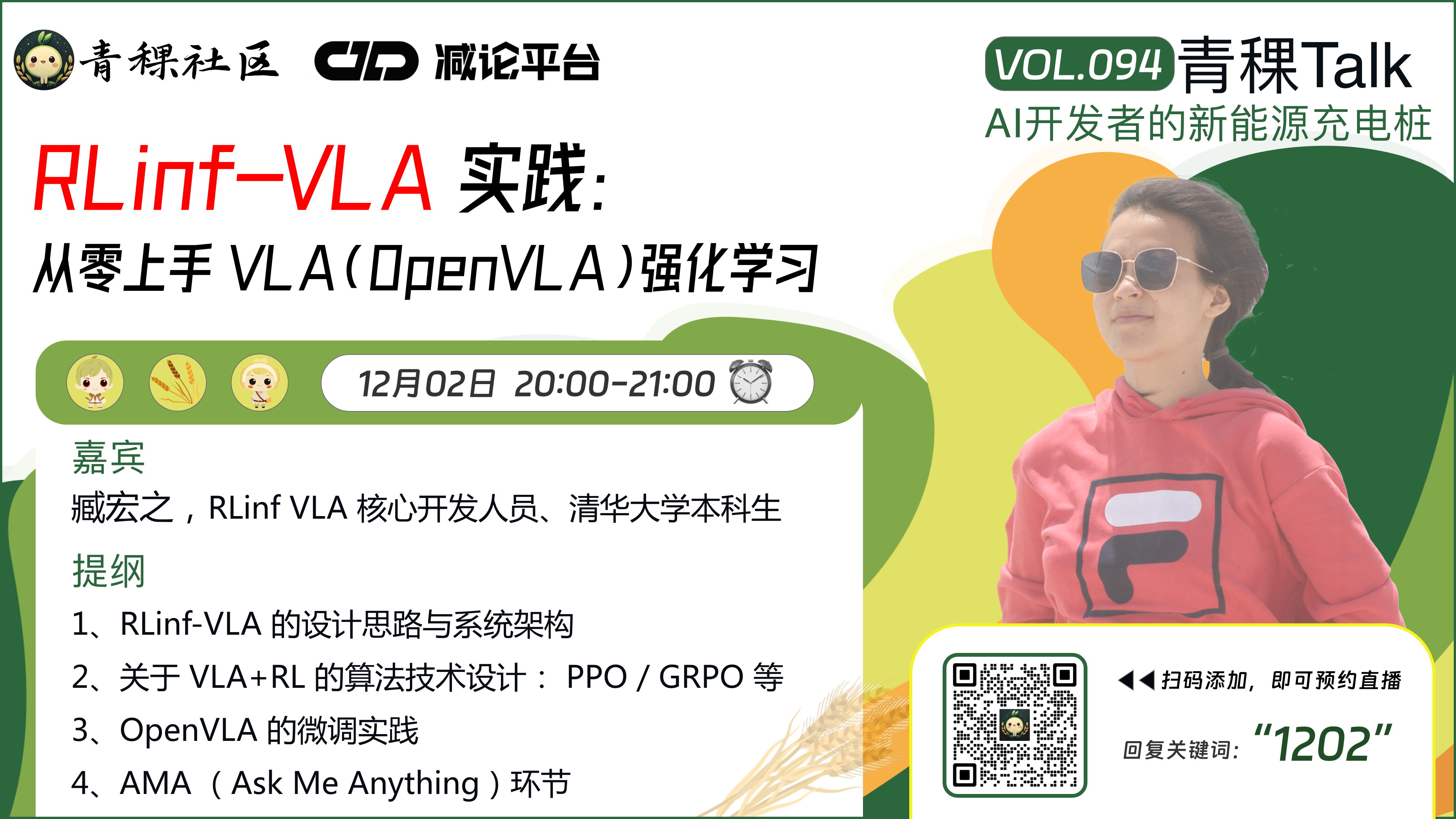

RLinf-VLA 实践:从零上手 VLA(OpenVLA)强化学习

手把手教你使用RLinf-VLA框架进行OpenVLA强化学习实践,入门具身智能开发。

深度对话!2025 "青稞" AI 嘉年华,与 20+ 位青年科学家一起探讨AI 技术瞬间

本次活动专为青年科学家打造,旨在搭建一场 AI 技术的深度对话,来自学术和工业界的 20+ 青年科学家,将与大家一起回顾 2025,展望 2026!

TRPO重生:大模型时代的信任域策略优化

在大型语言模型的强化学习阶段,特别是RLHF中,我们追求策略的持续优化。本次分享深入探讨TRPO在LLM时代的应用。

从 π_0 到 π_RL:面向流匹配 VLA 的强化学习后训练框架

深入解析流匹配VLA的强化学习后训练框架π_RL,探索具身智能的前沿技术。

RLinf:面向具身智能的"渲训推一体化"开源强化训练框架

开源强化训练框架RLinf,实现渲染、训练、推理一体化,加速具身智能研发。

RLinf-VLA 实践:从零上手 VLA(OpenVLA)强化学习

手把手教你使用RLinf-VLA框架进行OpenVLA强化学习实践,入门具身智能开发。

Join Us

Foundation Mastery

LLM/Multimodal fundamentals, code skills enhancement and engineering standards

Agent Architecture

Planning/Memory/Tool calling and evaluation, real business case breakdown

Project Co-creation

Hands-on project teaming, mentor Q&A and code review

Career Leap

Portfolio polishing, interview workshops, mentor recommendations and referrals

Deep Practice + Mentor Q&A + Project Co-creation

Portfolio polishing, code review, weekly retrospectives, referral recommendations. Limited spots per cohort to ensure interaction quality.

Partnership & Consultation

WeChat Official Account: AgentAlpha

Co-build community / Promotion partnerships / AI products / Training guidance, or need paper, project, career support, scan QR code to follow official account for more info.